Hyper-Intelligence

for human beings

Development of Artificial General Intelligence

and Strong Artificial Intelligence algorithms.

ABOUT US

ABOUT US

‘하인텔’ 은 ‘초지능(超知能)’을 뜻하는 Hyper Intelligence의 약어입니다.

하인텔㈜ 은, 범용 인공지능 혹은 강 인공지능 알고리듬의 개발을 목표로,

한국의 벤처 기업 ㈜클루닉스 의 설립자 권대석 박사에 의해

2022년 1월 설립 되었습니다.

하인텔㈜ 은 인간 지능의 본질을 알고리듬 수준에서 규명하여,

인간처럼 학습하고 판단하는

범용 인공지능Artificial General Intelligence 혹은

강 인공지능Strong Artificial Intelligence을 실현하고

특이점Singularity을 달성함으로써,

인류의 난제인 핵융합, 양자컴퓨팅, 상온초전도체, 암정복, 기후위기

등의 문제를 해결하려 합니다.

하인텔은 현재까지 거둔 성과를 사업화하여,

GPT 등 기존의 트랜스포머 기반 LLM이 달성하지 못한 수준의

GPU/메모리 절감을 실현하면서도

더 나은 품질의 초기학습(pre-training)과 추가학습(fine tuning)이

가능한 TIARA 솔루션과 TIARA-CC 솔루션을 개발, 공급하고 있습니다.

MISSION

Hyper-Intelligence for

human beings

하인텔㈜ 은 범용 강 인공지능을 통해,

인류의 생존과 공영에 기여하는 것을 최우선 목표로 하며,

이를 통해 합리적 수준에서 주주와 종업원의 경제적 이익을 달성하려 합니다.

하인텔㈜ 은 각 개인의 일상적 문제로부터,

지구 온난화, 경제 위기, 빈익빈 부익부, 정치적 이념적 대립 등의

국가적 혹은 전 지구적 문제에 이르기까지,

인간 수준 혹은 그 이상의 능력을 가진 인공지능을 통해,

실현 가능하고 지속 가능한 결책을 찾을 것입니다.

하인텔㈜ 은 인류를 위해, 혹은 개인의 도덕적이고 존경할만한 목적을 위해

개발 성과물을 제공, 활용케 하겠지만

어떤 경우에도 무상으로 제공하지는 않으려 합니다.

TEAM

CEO

권대석

CEO

권대석

1969년 서울에서 태어나, 1980년에 천체물리학자 칼 세이건의 코스모폴리타니즘과 인류 박애주의에 영향을 받고,

Apple-II 컴퓨터를 이용해 프로그래밍을 시작했습니다.

중학교 2학년인 1982년에 범용 인공지능의 개발을 평생의 목표로 삼고

1985년부터 Lisp, Prolog 등으로 Symbolic AI에 대해 공부했지만, 곧 그 한계를 깨닫고 새로운 방법을 찾기 시작했습니다.

1988년, 서울대학교에 입학, 인공신경망과 역전파학습을 공부하며 컴퓨팅 파워의 한계를 절감, 신경망 기반 지능 구현을 포기했습니다.

1990년, 인공신경망과 심볼릭 AI의 장점은 살리고, 단점은 줄이는 알고리듬을 연구한 끝에, 새로운 지능모델인

‘Self-organizing Active Network of Concepts’를 만들었으나,

컴퓨팅 파워의 부족과 슈퍼컴퓨터의 필요성을 절감하고

1992년, 서울대학교 병렬처리 연구실에 진학하여 '클러스터링'을 이용한 슈퍼컴퓨터의 개념을 제안,

1999년에 서울대학교에서 박사 학위를 받았습니다. 이후, 실리콘 밸리에 취직하게 되었으나,

2000년 1월, 선후배들의 권유와 ㈜우리기술의 투자로 슈퍼컴퓨팅 전문 기업 ㈜클루닉스를 창업해 22년간 경영하였습니다.

㈜클루닉스의 경영이 안정 궤도에 오름에 따라, 1991년에 만든 알고리듬이 최신형 컴퓨터에서 잘 동작하는지 테스트하여

좋은 결과를 얻고, 이를 완성하기 위해 2022년, 하인텔㈜을 창업하였습니다.

CTO

팽원기

CTO

팽원기

1985년 마산에서 태어나, 2003년 한양대학교 물리학과에 입학했습니다.

2013년에 한양대학교 물리학과에서 입자물리학으로 박사학위를 받았습니다.

2014년 3월부터 2018년 2월까지 기초과학연구원(IBS) 중이온가속기사업단에서 원자핵 및 핵물질에 대한 연구를 수행했습니다.

소립자, 핵자상호작용, 핵물질, 그리고 중성자별과 관련한 연구로 현재까지 총 13편의 SCI 논문을 발표했습니다.

2018년 4월, ㈜클루닉스에 입사하여 인공 지능에 대한 공부 및 연구를 시작했습니다.

2022년, 권대석 박사와 함께 하인텔㈜을 창업하였습니다.

2025년, GPT 등 생성형 LLM을 양자역학적으로 재해석한, 기념비적인 SCI 논문 1편을 발표했습니다.

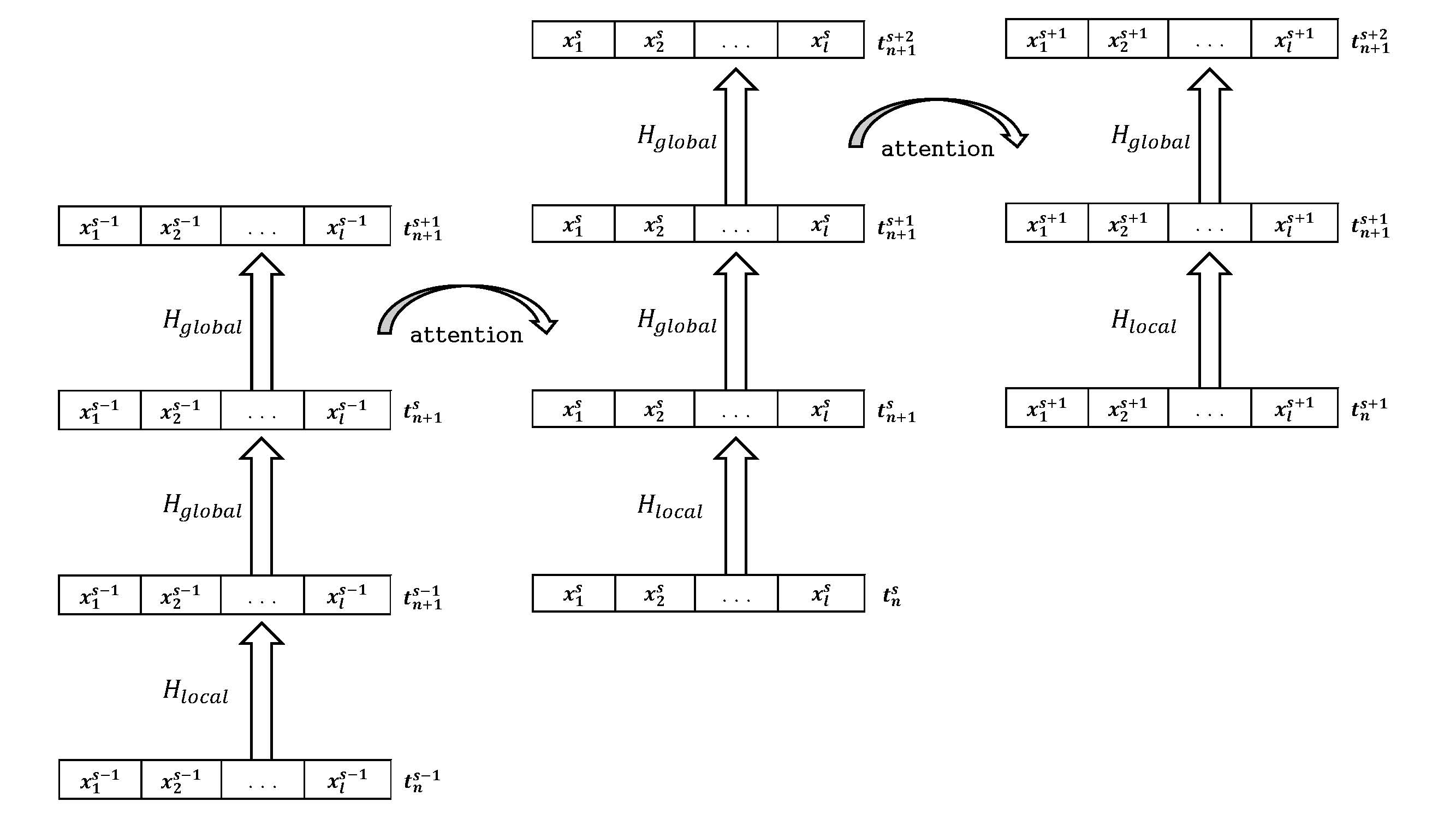

ALGORITHM:1

파인먼 경로적본으로 재해석된 주의기반 트랜스포머 : post-GPT 알고리즘

하인텔㈜의 post-GPT 알고리즘은 CTO 팽원기 박사의 양자 역학적 통찰로 주의기반 트랜스포머를 재해석하여,

트랜스포머 기반의 LLM들의 자원 이용량과 응답 품질을 획기적으로 개선하였습니다.

1. 트랜스포머에 의한 토큰의 변형은 경로적분에서 양자의 상태 변화와 수학적으로 동일하다.

2. 트랜스포머의 중간 처리결과를 적절히 가공, 유지, 활용함으로써 memory 사용량을 줄이면서 문맥 유지가 가능하다.

경로적분에 기반한, 알고리즘의 변형과 개선을 통해, 기존 LLM들의 자원 이용량과 품질을 획기적으로 개선할 수 있습니다.

ALGORITHM:2

보편적 지능에 대한 가설과 자기조직적 개념망(SANC) 모델

하인텔㈜의 인공지능 연구는 창업자 권대석 박사의 ‘보편적 지능에 대한 가설’에 기반하고,

그 가설을 입증하려는 시도입니다. 그 내용의 일부는 다음과 같습니다.

1. 지능은 어떤 분야, 어떤 수준에서든 동일한 기본 알고리듬으로 동작한다.

2. 지능은 ‘기존에 발생한 사건들’을 기억해 ‘다음에 발생할 사건을 예측’하는 블랙박스이다.

3. Hebbian learning을 비롯한, 극히 단순한 소수의 원리들만으로 모든 지능 활동을 재현할 수 있다.

-

보편성, 범용성

- 자연어 처리 뿐 아니라, 오류 검출, 영상 인식, 챗봇 구현,

필기체 인식에 모두 같은 알고리듬이 사용됩니다.- 형태소 분석이나 외곽선 검출과 같은 낮은 수준부터, 의미 분석이나 질의 응답,

창작과 같은 높은 수준까지 모두 같은 알고리듬이 사용됩니다.- 결과적으로, 고래나 외계인의 언어를 해석할 수 있고,

경제 위기나 내일 날씨를 예측할 수 있습니다. -

비지도 학습

- 어휘 사전이나 문법 정의, tagged training set 없이 raw data,

unprocessed corpus만으로 학습합니다. -

정제할 필요 없는, 작은 트레이닝 셋

- 수만 혹은 수억 단위의 큰 트레이닝 셋이 아니라 1/100 이하인

수백, 수천 단위의 트레이닝 셋만으로 학습이 가능합니다.- Tagged training set이 불필요하고, noisy data나 wrong data를 포함한

트레이닝 셋으로도 잘 학습합니다. -

빠른 학습 시간, 적은 전력 소모/컴퓨팅 파워 요구

- 단일 CPU로 수분 내에 학습합니다. 수백, 수천대의 GPU로 수개월간

학습할 필요가 없습니다. -

학습 단계와 활용 단계의 통합

- Active Network of Concepts 에서는 학습과 활용이 분리되지 않습니다.

결과적으로 학습중에 분석과 예측, 평가가 일어나고,

활용중에 학습이 일어납니다. -

명시적, 지시적 학습 및 교정 가능

- 학습된 네트워크에 특정 지식을 추가하거나, 기존 지식을 손쉽게 교정할 수 있습니다.

-

추적 가능성

- 네트워크가 산출한 결과가 어떤 과정에 의해 도출되었는지

추적 가시화할 수 있습니다.

SOLUTION

TIARA (Task Information Activated Role Adaptor)

만약 기존 LLM이 학습했을 것 같지 않은, (어려운) 박사 수준의 지식을 추가학습시켜야 하거나,

우리 회사만의 고유 데이터를 외부 유출 없이, 적은 GPU만으로 빠르게 학습시키고 쉽게 교체하고 싶다면 티아라TIARA를 떠올려 주십시오.

TIARA는 라마나 DeepSeek, Exaone 같은 대규모 언어모델(LLM)에 특정 분야의 지식이나 고객 자신만의 데이터를 추가학습 시킬 때,

수십~수백장 이상의 GPU를 요구하는 풀-파인튜닝 이상의 학습 품질을 보장하면서 GPU 사용량을 1/10 이하로 절감하게 하는 딥러닝 솔루션입니다.

TIARA를 사용함으로써 고객은 외부 공유가 곤란한 자체 보유 데이터나 특정 분야 고급 지식을 10장 미만의 GPU 만으로 빠르게 추가학습 시키고,

내용 갱신이 필요할 경우, 기존 LLM을 건드리지 않고, 기존 TIARA 모듈만을 새로 학습된 TIARA 모듈로 교체함으로써 갱신된 새로운 내용을 손쉽게 반영할 수 있습니다.

TIARA는 고객이 원하는 LLM을 학습시키거나 변경시키지 않습니다. (비침습적 추가학습)

고객이 원하는 LLM에 TIARA를 적용하는 것만으로, 기존의 LLM에 특정 분야 전문지식이나 고객 고유 지식 자산을 추가 학습시키고

추가 학습 결과를 탈부착할 수 있습니다. 마치 영화 '매트릭스'의 대사 - "나는 이제 태극권을 할 수 있어" 처럼!!!

TIARA를 메타의 Llama 3.1, 1B 모델에 적용할 경우, 결과적으로 1.1B 모델이 생성됩니다.

0.1B 크기의 티아라 모듈은 더 적은GPU로 쉽게 학습하고,

쉽게 교체할 수 있을 뿐 아니라, 1B 모델을 풀 파인튜닝한 것보다

더 나은 학습 품질을 보여 줍니다.

상세 기술 설명을 위해서는 회사 및 기술 소개 자료를 참조하시거나 메일로 문의해 주십시오.

CONTACT US

contact@hyntel.net